Schutz vor Adversarial Attacks

Schutzperspektiven für Machine Learning Systeme

Die Anwendung von Systemen des maschinellen Lernens (Machine Learning) im Bereich der Objekterkennung und Objektklassifizierung – etwa zur Erfassung von Verkehrsschildern in autonomen Fahrzeugen – hat in den vergangenen Jahren bedeutende Fortschritte erzielt. Diese Entwicklung ermöglicht den Einsatz von entsprechenden Systemen in zahlreichen Bereichen, die schon bald den Lebensalltag prägen werden. Damit einhergehend kommt es jedoch zu neuen Gefahrenpotentialen, die nicht unterschätzt werden sollten. So wird in den Computerwissenschaften seit einiger Zeit von Ansätzen berichtet, die darauf abzielen, die Funktionsweise solcher Systeme zu torpedieren. Die Rede ist insbesondere von sog. "Adversarial Attacks".

Solche "Angriffe" erfolgen durch den Einsatz sog. "Adversarial Examples", die eingesetzt werden, um Klassifikationsergebnisse fehlzuleiten. Hierfür werden bestimmte Signale gezielt manipuliert, sodass ein Objekt (z.B. ein Strassenverkehrsschild) falsch erkannt wird. Diese Manipulationen, deren Einsatz unter anderem in der Bild-, Text- und Spracherkennung bekannt ist, sind in vielen Fällen für das menschliche Auge nicht ohne Weiteres erkennbar: von den "Angreifern" werden zum Beispiel Pixel eines Bildes subtil verändert oder ein kaum wahrnehmbares Rauschen eingefügt. Das System ordnet die abgebildeten Objekte anschliessend falsch zu. Neben diesen zweidimensionalen Bearbeitungen ist es in der Zwischenzeit gelungen, die Systeme durch dreidimensionale Objekte mit spezifischen Mustern fehlzuleiten. Dies schafft weitere Gefahren, deren Auswirkungen sich zum derzeitigen Zeitpunkt nur schwerlich abschätzen lassen.

Neben technischen Ansätzen zur Gefahrenabwehr drängt sich die Frage auf, ob und welche rechtlichen Instrumente gegen "Adversarial Attacks" mobilisiert werden können. Prof. Dr. iur. Alfred Früh und sein Team untersuchen dies im Rahmen eines ZLSR-Projektes aus einer umfassenden rechtlichen Perspektive. Dabei geht der Blick bereits aufgrund der internationalen Dimension dieser Thematik über den nationalen Rechtsrahmen hinaus und erfasst auch alternative regulatorische Lösungen. Das ZLSR arbeitet in diesem Projekt im Rahmen interdisziplinärer Workshops mit ausgewählten Forschenden zusammen.

Publikationen:

Fausch, I.; Zeyer, D. (2024) “Angriffe auf KI-Systeme”

Früh,A.; Haux, D.H. (2024) "Technical Countermeasures against Adversarial Attacks on Computational Law"

Früh, A.; Haux, D.H. (2022) “Foundations of Artificial Intelligence and Machine Learning”

Vorträge und Veranstaltungen:

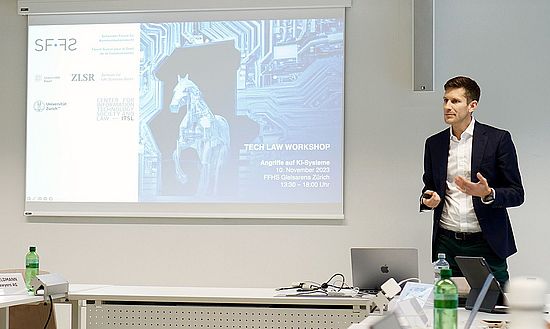

Tech Law Workshop - Angriffe auf KI Systeme, organisiert vom Schweizer Forum für Kommunikationsrecht (SF FS) in Kooperation mit dem Zentrum für Life Sciences-Recht (ZLSR) und dem Center for Information Technology and Society and Law (ITSL), FFHS Gleisarena Zürich, 10.11.2023

> Dario Haux, Privatrechtliche Schutzperspektiven für ML-Systeme, Impulsreferat, Swiss Internet Governance Forum (Swiss IGF), BAKOM, Bern, 02.06.2022

> Alfred Früh/Dario Haux, Immaterialgüterrechtlicher Schutz vor Adversarial Attacks. Privatrechtliche Schutzperspektiven für Machine Learning Systeme, Präsentation, Vertiefung im Immaterialgüter- und Wettbewerbsrecht: Aktuelle Wissenschaft – Werkstattberichte & Diskussion, Lehrstuhl für Zivilrecht X (Prof. Dr. Michael Grünberger, LL.M. (NYU)), Bayreuth (via Zoom), 08.12.2021

Impressionen des Workshops